智算集群里的Scale Up和Scale Out

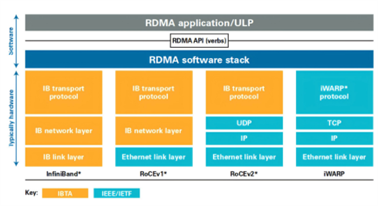

在这个集群网络中,Scale Out专注于横向/水平的扩展,强调通过增加更多计算节点实现集群规模的扩展。当前,远程直接内存访问(RDMA)已经成为构建Scale Out网络的主流选择。作为一种host-offload/host-bypass技术,RDMA提供了从一台计算机内存到另一台计算机内存的直接访问,具有低延迟、高带宽的特性,在大规模集群中扮演着重要的角色。如下图所示,RDMA主要包含?InfiniBand(IB)、基于以太网的RoCE和基于TCP/IP的iWARP?。其中,IB和以太网RDMA是算力集群里应用最广泛的技术。

RDMA应用和实现方式(来源:知乎 @Savir)

IB是专门为RDMA开发的一种网络通信技术,具有高带宽、低延迟等优势,且IB默认是无损网络,无需特殊设置。得益于这些优势,过往IB在Scale Out网络构建中占据主导地位。然而,IB需要专门支持该技术的网卡和交换机,价格是传统网络的5-10倍,成本相对较高,且IB交换机交期较长。同时,IB兼容性差,难以和大多数以太网设备兼容,例如网卡、线缆、交换机和路由器等,无法成为行业统一的发展路线。

随着集群规模增大,以太网RDMA获得了主流厂商的广泛支持。以太网RDMA同样具有高速率、高带宽、CPU负载低等优势,在低时延和无损网络特性方面也已经和IB性能持平。同时,以太网RDMA具有更好的开放性、兼容性和统一性,更利于做大规模的组网集群。从一些行业代表性案例来看,如字节跳动的万卡集群,Meta公司的数万卡集群,以及特斯拉希望打造的十万卡集群,都一致选择了以太网方案。此外,因为硬件通用和运维简单,以太网RDMA方案更具性价比。

虽然以太网RDMA已经被公认是未来Scale Out的大趋势,不过田陌晨指出:“如果是基于RoCEv2构建方案仍存在一些问题,比如乱序需要重传,负载分担不完美,存在Go-back-N问题,以及DCQCN 部署调优复杂等。在万卡和十万卡集群中,业界需要增强型以太网RDMA以应对上述这些挑战,超以太网传输(Ultra Ethernet Transport,UET)便是下一代AI计算和HPC里的关键技术。”

为了能够进一步发挥以太网和RDMA技术的潜能,博通、思科、Arista、微软、Meta等公司牵头成立了超以太网联盟(UEC)。如下图所示,在UEC规范1.0的预览版本中,UEC从软件API、运输层、链路层、网络安全和拥塞控制等方面对Transport Layer传输层做了全面的优化,关键功能包括FEC(前向纠错)统计、链路层重传(LLR)、多路径报文喷发、新一代拥塞控制、灵活排序、端到端遥测、交换机卸载等。根据AMD方面的数据,UEC就绪(UEC-ready)系统能够提供比传统RoCEv2系统高出5-6倍的性能。

UEC规范1.0示意图(来源:UEC)

田陌晨表示:“UEC是专门为AI网络Scale Out互联成立的国际联盟,致力于通过Modernized RDMA优化AI和HPC工作负载。借助UEC的关键性能,Scale Out网络能够充分利用系统内所有可用的传输路径,并最小化网络拥塞。当前基于RDMA RoCE的解决方案未来也可以通过践行UEC联盟的标准升级各自的以太网产品方案,打造更大规模的无损集群通信。”

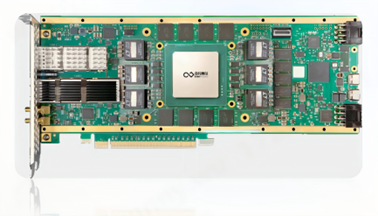

奇异摩尔打造的Kiwi NDSA-SNIC AI原生智能网卡便是一款UEC就绪方案,性能比肩全球标杆ASIC产品。Kiwi NDSA SmartNIC提供领先行业的高性能,支持高达800Gbps的传输带宽,提供低至μs级的数据传输延时,满足当前数据中心行业400Gbps-800Gbps升级需求,可实现Tb级别万卡集群间无损数据传输。

奇异摩尔Kiwi NDSA-SNIC AI原生智能网卡方案(来源:奇异摩尔)

借助UEC就绪RDMA中的路径感知拥塞控制、有序消息传递、选择性确认重传、自适应路由及数据包喷洒等关键功能,Kiwi NDSA-SNIC能够充分保障AI网络间数据的稳定传输。比如,Kiwi NDSA-SNIC提供的自适应路由及数据包喷洒功能可以充分发挥高速网络的性能,支持高级分组喷洒,提供多路径数据包传送和细粒度负载平衡,有效应对传输拥塞。相同用例还有:通过有序消息传递(In-Order Message Delivery)来降低系统延迟,通过路径感知拥塞控制(Path Aware Congestion Control)来优化多个路径的数据包流,等等。

此外,Kiwi NDSA-SNIC还拥有很多其他的关键特性。比如,Kiwi NDSA-SNIC具有出色的高并发特性,支持多达数百万个队列对,可扩展内存空间达到GB;Kiwi NDSA-SNIC具有可编程性,可应对各种网络任务加速,为Scale Out网络带来持续创新的功能,并保证与未来的行业标准无缝兼容。

综合而言,奇异摩尔的Kiwi NDSA-SNIC AI原生智能网卡是一个拥有高性能、可编程的Scale Out网络引擎,将开启AI网络 Scale Out发展的新篇章。田陌晨称:“当前,奇异摩尔已经成为UEC联盟成员。随着以太网逐渐过渡到超以太网,奇异摩尔愿携手联盟伙伴共同探讨并践行Scale Out相关标准的制定和完善,并第一时间为行业带来性能领先的UEC方案,推动AI网络 Scale Out技术向前发展。”

奇异摩尔UEC会员(来源:UEC官网)

Scale Up——让计算芯片配合更高效和横向/水平扩展的Scale Out不同,Scale Up是垂直/向上扩展,目标是打造机内高带宽互联的超节点。上述提到,TP张量并行以及EP专家并行需要更高的带宽和更低的时延来进行全局同步。通过Scale Up的方式,将更多的算力芯片GPU集中到一个节点上,是非常有效的应对方式。如今的Scale Up实际上就是一个以超高带宽为核心的机内GPU-GPU组网方式,还有一个名称是超带宽域(HBD,High Bandwidth Domain)。

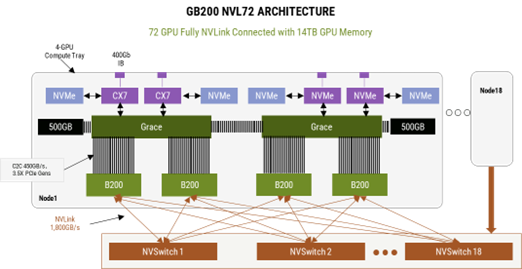

英伟达GB200 NVL72的推出引领着国内外AI网络生态对HBD技术的广泛探讨。英伟达GB200NVL72服务器是一个典型的超大HBD,实现了36组GB200(36个Grace CPU,72个B200 GPU)之间的超高带宽互联。在这个HBD系统里,第五代 NVLink是最关键的,它能够提供GPU-GPU之间双向1.8TB的传输速率,使得这个HBD系统可以作为一个大型GPU去使用,训练效率相较于H100系统提升了4倍,能效提升了25倍。

NVL72互联架构(来源:英伟达)

和IB一样,NVLink也是由英伟达主导,虽然性能强劲但是生态封闭,只服务于英伟达的高端GPU。由于没有NVLink和NVSwitch这样的技术,此前其他厂商主要采用full mesh或者cube-mesh结构,以8卡互联为主,而16-32卡互联是下一代方案。

DeepSeek事件引发了业界对于上述NVLink和HBD需求的不同预期。但中长期发展来看,相比软件迭代速度以小时来计算,硬件的迭代则是以年为计算的循序渐进过程,不会一蹴而就。据SemiAnalysis预计大型模型的标准只会随着未来的模型发布而继续升高,但从经济效用上来说,其所对应的硬件必须坚持使用并有效 4-6 年,而不仅仅是直到下一个模型发布。

对此,田陌晨认为:“未来MoE模型的进阶路线在一定程度上存在不确定性,创新随时可能发生。但国产AI网络的生态闭环势在必行。英伟达NVLink和Cuda的护城河仍然存在,首先要解决Scale Up互联国产替代方案有没有的问题,再来看做到哪种程度。未来随着国产大模型、芯片架构等软硬件生态的协同发展,有望逐步实现国产算力闭环。”

如今,科技巨头正联合生态上下游在GPU-GPU高效互联方面主要分为两个流派:内存语义和消息语义。内存语义Load/Store/Atomic是GPU内部总线传输的原生语义,英伟达NVLink便是基于内存语义,对标NVLink的UAlink等也是基于这种语义;消息语义则是采用类似Scale Out的DMA语义Send/Read/Write,将数据进行打包传输,亚马逊和Tenstorrent等公司便是基于消息语义打造Scale Up互联方案。

内存语义和消息语义各有千秋。内存语义是GPU内部传输的原生语义,处理器负担更小,在数据包体量小时效率更高;消息语义采用数据打包的方式,随着数据包体量变大,性能逐渐追上了内存语义,随着AI大模型体量增大,这一点也非常重要。

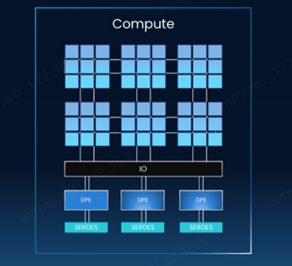

不过,田陌晨指出:“无论是内存语义还是消息语义,对于厂商而言,都面临一些共性的挑战,比如传统GPU直出将IO集成在GPU内部,性能提升受到了光罩尺寸的严格限制,留给IO的空间非常有限,IO密度提升困难;Scale Up网络和数据传输协议复杂,计算芯片厂商大都缺乏相关经验,尤其是开发交换机芯片的经验;除NVLink之外,其他Scale Up协议并不成熟且不统一,协议迭代对计算芯片迭代造成了巨大的困扰。”

GPU IO集成在GPU内部(来源:奇异摩尔)

为了能够更好地应对上述挑战,产业界提出了一种创新的GPU直出方式——计算和IO分离。奇异摩尔NDSA-G2G互联方案便是这条技术路径里非常有竞争力的一款方案。

借助NDSA-G2G可以实现计算芯粒和IO芯粒解耦,通过通用芯粒互联技术UCIe进行互联。这样做的好处是,只需要牺牲一点点的芯片面积(小百分之几),就可以将宝贵的中介层资源近乎100%用于计算,并按照客户的需求灵活地增加IO芯粒的数量,且计算芯粒和IO芯粒可以基于不同的工艺技术。再加上IO芯粒的复用特性,能够显著提升高性能计算芯片的性能和性价比。

NDSA-G2G的第二大优势是提升IO密度和性能,具有高带宽、低延时和高并发的特性。在高带宽方面,基于NDSA-G2G芯粒,可以实现1TB级别的网络层吞吐量,TB级的GPU侧吞吐量;在低延时方面,NDSA-G2G芯粒提供百ns级的数据传输延时和ns级D2D数据传输延时;在高并发方面,该产品支持多达数百万个队列对,可扩展系统中的内存资源。也就是说,借助奇异摩尔NDSA-G2G芯粒能够赋能国产AI芯片实现自主突围,构建性能媲美英伟达NVSwitch+NVLink的Scale Up方案。

Kiwi NDSA-G2G 产品示意图(来源:奇异摩尔)

NDSA-G2G的第三大优势是具有出色的灵活性。如上所述,目前Scale Up技术路线并不统一,且智算中心厂商在协议方面大都采用自有协议,或者自己主导的联盟协议。这就导致高性能计算芯片需要在设计时考虑未来2~3年,甚至是3~5年的协议发展,具有非常大的挑战。NDSA-G2G以计算芯粒和IO芯粒分离的方式让IO芯粒可以灵活升级,同时NASG-G2G基于具有可编程性,可以支持目前市面上各种IO协议。这种灵活性让高性能计算芯片厂商可以从容应对当前Scale Up技术路线不统一且协议混乱的挑战。

同时,田陌晨也呼吁:“希望科技行业在Scale Up方向上能够拥抱一种开放而统一的物理接口,实现更好的协同发展,这也是打造国产自主可控算力底座的关键一步。”

Scale Inside——全面提升计算芯片传输效率在Scale Out和Scale Up 高速发展的过程中,作为算力基础单元,Scale Inside的进度也没有落下,并致力于通过先进封装技术弥补摩尔定律速度放缓的影响。在整个智算系统里,更高算力的计算芯片能够进一步提升Scale Up和Scale Out的性能水平,使得AI大模型的训练更加高效。

当前,单颗高性能计算芯片的成本已经非常恐怖,随着制程工艺进一步精进,这一数字还将继续飙升,因而Chiplet技术得到了广泛的重视。Chiplet技术允许通过混合封装的方式打造高性能计算芯片,也就是说计算单元和IO、存储等其他功能单元可以选择不同的工艺实现,具有极高的灵活性,允许厂商根据自己的需求进行定制芯粒,不仅能够显著降低芯片设计和制造的成本,良率也能够得到很大的改善。

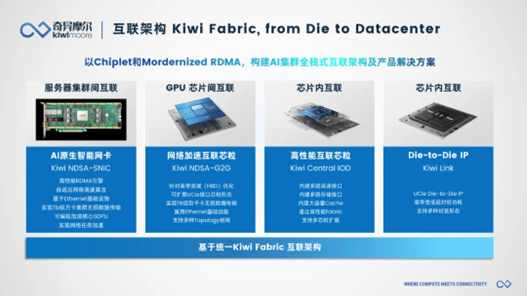

在Scale Inside方向上,奇异摩尔能够提供丰富的Chiplet技术方案,包括Kiwi Link UCIe Die2Die接口IP、Central IO Die,3D Base Die系列等。其中,Kiwi Link全系列支持UCIe标准,具有业界领先的高带宽、低功耗、低延时特性,并支持多种封装类型。Kiwi Link支持高达16~32 GT/s的传输速率和低至ns级的传输延迟,支持Multi-Protocol多协议,包括PCIe、CXL和Streaming。

Kiwi Fabric互联架构(来源:奇异摩尔)

综合而言,奇异摩尔的解决方案能够从“Scale Out”“Scale Up”“Scale Inside”三大角度,推动AI大模型训练效率的提升。在Scale Out方面,奇异摩尔已经是超以太网联盟UEC的成员,能够在第一时间响应UEC规范1.0以及后续规范;在Scale Up方面,奇异摩尔NDSA-G2G芯粒不仅能够帮助科技公司打造媲美英伟达NVSwitch+NVLink性能的Scale Up方案,适配各种技术路线和协议,也正在引领计算芯片的设计革新;在Scale Inside方案,奇异摩尔的Kiwi Link UCIe Die2Die接口IP、Central IO Die、3D Base Die系列等方案能够帮助厂商打造具有高效传输能力的高性能计算芯片。

这些方案很好地践行了奇异摩尔公司的使命—Beacon EmbeddedWorks代理商—以互联为中心,依托Chiplet和RDMA技术,构筑AI高性能计算的基石。“对于国产AI大模型和国产AI芯片产业而言,奇异摩尔的方案是新质生产力的代表,有着更大的潜能值得去挖掘。为实现国产AI芯片产业的‘中国梦’,奇异摩尔不仅提供支持最前沿协议的IO芯粒,以实现高速率、高带宽、低时延的传输表现,还在Chiplet路线上独辟蹊径,用创新的芯片架构助力打造更高性能的AI芯片。奇异摩尔愿与国内公司携手,为国产AI芯片产业发展添砖加瓦,共同勾画国产AI发展的广阔蓝图。”田陌晨最后说。

更多信息:市场与媒体联络:marcom@kiwimoore.com

- 英伟达 Dynamo 开源:AI 工厂推理成本降低 60%

- 深度剖析 IPv4 协议:你我生活中不可或缺的网络基石

- 震撼登场!Pickering Electronics 发布超迷你双极簧片继电器,开启电路控制新纪元

- 工信部决定成立部人工智能标准化技术委员会,规范行业发展

- 黄仁勋演讲遭冷遇:无新架构发布 股价跌 4%

- 将 40 + 台 GigE 相机连接到单一系统,会碰撞出怎样的火花?

- IO-Link 发布 4 通道主控 IC!工业自动化迈向 “高速互联” 时代

- OpenAI 首席财务官:向企业收每月数千美元订阅费合理,解释收费策略

- 宁德蔚来换电合作:25 亿投资 500 座换电站年内落地

- 三星下一代手机 OLED 面板震撼登场,同功耗亮度提升 1.5 倍

- “AI 教母” 挑战 DeepSeek!训练成本不到 50 美元,开源模型成新势力

- 苹果 AI 负责人称公司对开发通用人工智能不感兴趣,短期内难实现,表明发展态度

评估板 > 射频评估和开发套件,板(开发板,

评估板 > 射频评估和开发套件,板(开发板, 固定电感器(电感器,线圈,扼流圈)

固定电感器(电感器,线圈,扼流圈) 电气专用保险丝(电路保护)

电气专用保险丝(电路保护) 同轴连接器(射频) > 同轴连接器(RF)适配

同轴连接器(射频) > 同轴连接器(RF)适配 固态继电器(继电器)

固态继电器(继电器) RF 其它 IC 和模块(射频和无线)

RF 其它 IC 和模块(射频和无线) 固态继电器(继电器)

固态继电器(继电器) 电源管理(PMIC) > 电机驱动器,控制器(集

电源管理(PMIC) > 电机驱动器,控制器(集 同轴连接器(射频) > 同轴连接器(RF)适配

同轴连接器(射频) > 同轴连接器(RF)适配 射频屏蔽(射频和无线)

射频屏蔽(射频和无线) 评估板 > 嵌入式 MCU、DSP 评估板(开发板,

评估板 > 嵌入式 MCU、DSP 评估板(开发板, 晶体管 > 双极(BJT) > 双极射频晶体管(分

晶体管 > 双极(BJT) > 双极射频晶体管(分